PoplarML - 将模型部署至生产环境 工具信息

PoplarML - 将模型部署至生产环境 是什么?

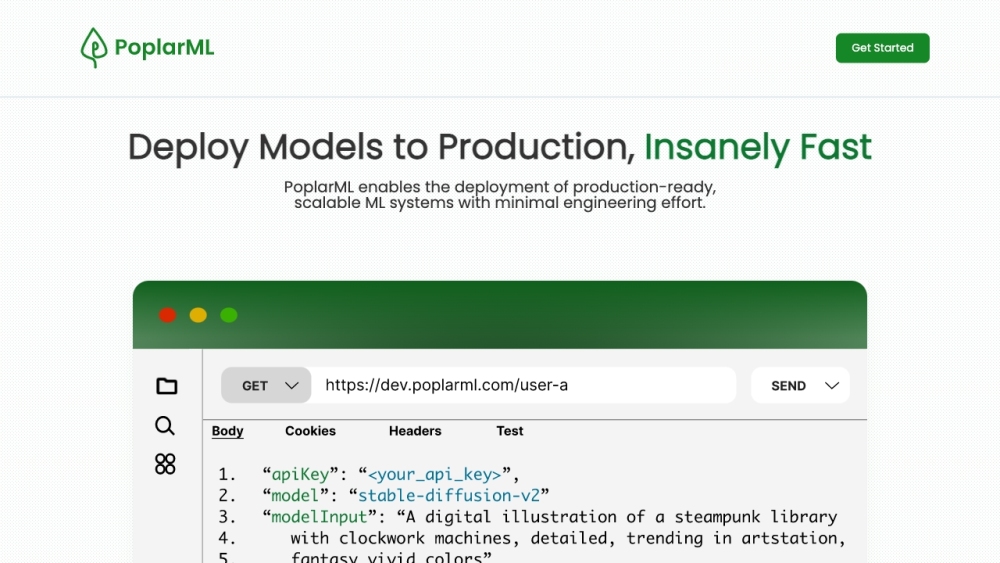

使用PoplarML,您可以简化机器学习(ML)模型在生产环境中的部署过程,而无需进行工程化工作。PoplarML提供了一个交互式的CLI工具,使得部署到多台GPU上的ML模型变得容易且高效。此外,它还支持Tensorflow、Pytorch和JAX等流行框架,用户可以在使用这些库构建的模型上进行实时推理。 如何使用PoplarML? 1. 注册一个帐户并访问网站。 2. 使用提供的CLI工具将您的ML模型部署到一组GPU上。 3. 通过REST API端点调用模型进行实时预测。 4. 携带Tensorflow、Pytorch或JAX等流行的ML框架,PoplarML会自动处理部署过程。 功能列表: - 使用CLI工具无缝部署ML模型到GPU - 通过REST API端点实现实时推理 - 支持Tensorflow、Pytorch和JAX等流行框架 应用示例: - 将ML模型部署至生产环境 - 扩展ML系统以最小的工程化努力 - 实时推理已部署的模型 - 确保模型使用多种ML框架 常见问题解答: 1. PoplarML是什么? PoplarML是一个平台,它允许您轻松部署生产就绪且可扩展的机器学习模型。 2. 如何使用PoplarML? 注册一个帐户并访问网站。然后使用提供的CLI工具无缝部署您的ML模型到一组GPU上。通过REST API端点调用模型进行实时推理。 3. PoplarML的核心功能是什么? 主要功能包括:使用CLI工具无缝部署ML模型到GPU、通过REST API端点实现实时推理、支持Tensorflow、Pytorch和JAX等流行框架。 4. PoplarML的用途是什么? 适用于将ML模型部署至生产环境,以最小的工程化努力扩展ML系统,实时推理已部署的模型。同时支持多种ML框架。

PoplarML - 将模型部署至生产环境 有哪些功能?

- 使用CLI工具无缝部署ML模型到GPU

- 通过REST API端点实现实时推理

- 支持Tensorflow、Pytorch和JAX等流行框架

PoplarML - 将模型部署至生产环境 怎么使用?

使用PoplarML,您只需遵循以下步骤: 1. 注册一个帐户并访问网站。 2. 使用CLI工具将您的ML模型部署到GPU上。 3. 通过REST API端点调用模型进行实时推理。 4. 携带Tensorflow、Pytorch或JAX等流行的ML框架,PoplarML会自动处理部署过程。

PoplarML - 将模型部署至生产环境 的使用案例

- 将ML模型部署至生产环境

- 扩展系统以最小工程化努力

- 实时推理已部署的模型

- 确保支持多种框架

PoplarML - 将模型部署至生产环境 的常见问题

相关文章

暂无相关文章